在AI模型訓練完成,開始向使用者提供服務後,AI推論需求將遠大於訓練需求。因此,許多大廠早在數年前便開始研發雲端專用的純推論晶片,希望搶得先機。但目前這類純推論晶片的開發計畫多已宣告終止,顯示純推論晶片的發展似乎遭遇困境。

人工智慧硬體加速晶片歷經數年的發展已逐漸演變出三個佈建位置、兩種取向設計,三佈建位置分別是雲端(Cloud)、邊緣(Edge)、裝置(Device),後兩者是之後的衍生演化,也稱為Edge AI或On-Device AI/TinyML。

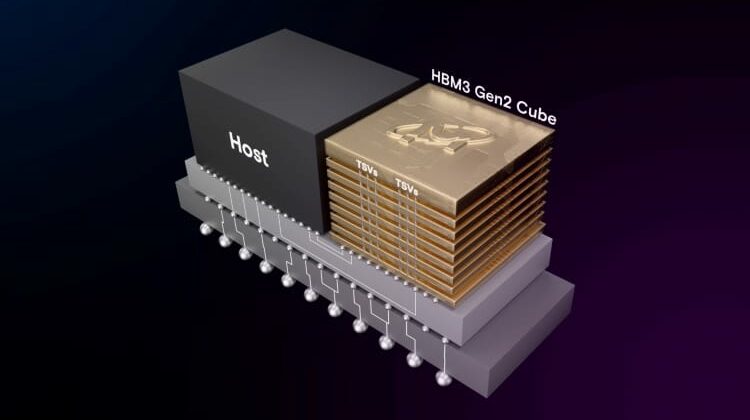

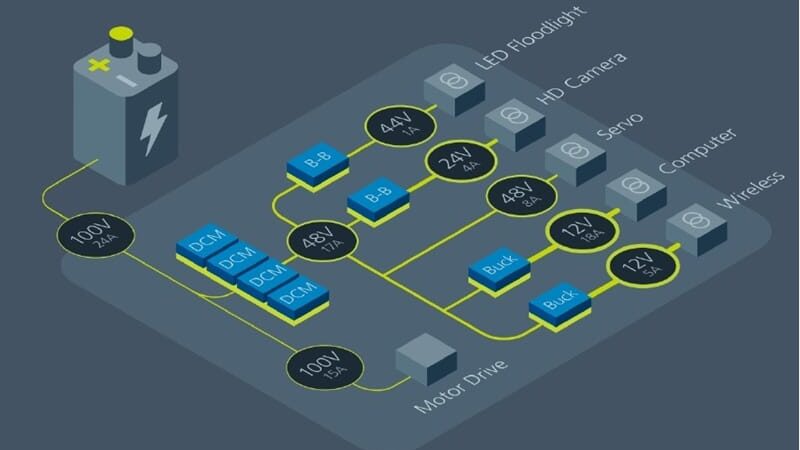

若對應到晶片,雲端是在碩大的資訊機房內放置大量伺服器,在伺服器內加插硬體加速卡,卡上即有AI硬體加速晶片,或直接在伺服器主機板上設置晶片;而邊緣則是在物聯網閘道器、工業電腦系統內加插硬體加速卡或模組子卡,卡上一樣有AI硬體加速晶片;至於TinyML則為極小的離散封裝加速晶片,或以矽智財方式在設計階段便已嵌入至裝置主控晶片內。

所謂的兩種取向,一是訓練、推論合一的晶片,另一是訓練、推論各自分立的晶片。在邊緣或裝置位置上,實際上只有配置推論型晶片,因為模型訓練多需要集中的資料,邊緣與裝置處於分散的位置,只適合向後傳遞收容的新資料,自身不適合訓練。表1是AI加速晶片布建位置與設計取向對應表。

而推論工作之所以要下放到邊緣、裝置,而非集中在雲端,主要是部份AI應用情境需要即時獲得推論結果,如車聯網(V2X)需要即時識別擋風玻璃外的景物,將影像傳遞到雲端,雲端完成推論判別後再回傳至車內,景物通常已經錯過。

所以,只有雲端有兩種設計取向的議題,一是配置訓練、推論合一型晶片,另一是配置專屬的訓練型晶片及專屬的推論型晶片,且在雲端的晶片,其推論工作不需要如邊緣、裝置般即時回應。

推論工作將成大宗 專屬晶片想法萌生

既然雲端同時有訓練與推論的需求,只要使用合一型晶片即可,為何會有分別設計晶片的想法?此主要根據觀察,AI模型約花1成時間選擇演算法與試錯,約2成時間在於模型訓練,訓練一旦完成,7成時間都在推論,而後重新進入試錯、訓練。

既然推論佔據大多數時間,想定未來AI應用成熟普及,則多數地方多數時間都在推論,訓練反成為短暫、臨時性需求。因此,若為了讓運算更具低成本、低功耗,有必要額外開設專屬晶片。

循此思路,業界於2018、2019年陸續提出雲端專屬的推論型晶片,如AWS的Inferentia系列、高通(Qualcomm)的Cloud AI 100、英特爾(Intel)購併Nervana後提出的NNP-I、英特爾購併Habana而有的Goya、Meta(Facebook母集團)的MTIA v1/v2,都屬於機房端的重度推論專用型晶片。這些專門用來執行推論任務的晶片,功耗可接近100瓦,甚至更高。

雖然有晶片商提出訓練、推論分離的技術主張,但也有業者堅持合一作法,如英國新創Graphcore認為,推論過程中獲得的新資料很快又會投入訓練,時間與週期將越來越近,因此採合一設計,然此論調也可能是自身研發資源有限下不得不採行的路線。

不過,不單是Graphcore,NVIDIA Tesla(2020年避免與電動車品牌混淆而棄用Tesla之名)系列、Google TPU系列、微軟(Microsoft) Maia 100等大廠的雲端AI晶片,也都採取訓練、推論合一設計,故不純然是研發資源因素。

雲端專用推論晶片逐漸式微

重量級業者雖陸續推出雲端推論型晶片,但近年來卻出現難以為繼的窘境,例如英特爾全面停止Nervana,改用Habana。但即便改用Habana,也已停止開發推論專用的Goya系列晶片,只保留Gaudi系列晶片。Gaudi晶片原先設定是訓練專用型晶片,也重新定位成合一型晶片。

AWS在發展Inferentia系列數年之後,在2024年12月例行技術年會re:Invent期間也表示,為了集中發展訓練專用的Trainium系列晶片,將停止Inferentia系列的發展。這也成了AWS首個停止發展的晶片系列,其他如Nitro系列、Graviton系列、Trainium系列等維持發展。

進一步的,2025年1月CES期間,高通提出「on-premises AI appliance」硬體,專供邊緣推論用,推測也在調整晶片應用方向,將原有的雲端定位轉向或延伸至邊緣。

因此,目前雲端推論型晶片大體只剩下Meta的MTIA(Meta Training and Inference Accelerator,雖名為訓練與推論,但目前以推論為主)還在持續發展。不過,MTIA晶片的功耗為20瓦(v1)、90瓦(v2),理論上也能布建在邊緣。一般而言,功耗百瓦以上的晶片才能完全確定其只能布建於雲端。

以此為衡量依據,高通Cloud AI 100系列晶片依據不同型號,功耗在75瓦至150瓦之間,高階確定僅適合用於資訊機房、資料中心內的伺服器,低階則仍有機會用於邊緣。

想定偏誤或過早布局? 純推論晶片面臨轉型壓力(1)