英特爾(Intel)與NVIDIA正面交鋒。人工智慧晶片競爭越來越激烈,Intel於測試報告中指出,新推出的Intel Xeon Phi處理器系列,其運算能力高於目前市面上GPU處理器。針對此份報告內容,NVIDIA不以為然,並以旗下新款專為深度學習打造的運算系統–DGX-1為例,撰寫一篇部落格反擊Intel,兩大人工智慧晶片廠商隔空交火,也使得人工智慧戰場更加熾熱。

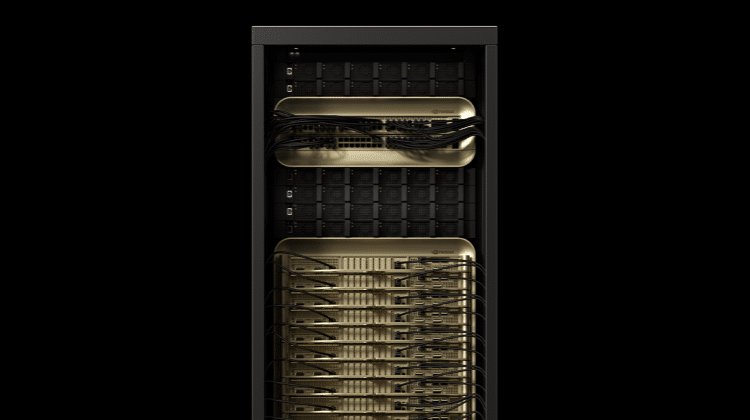

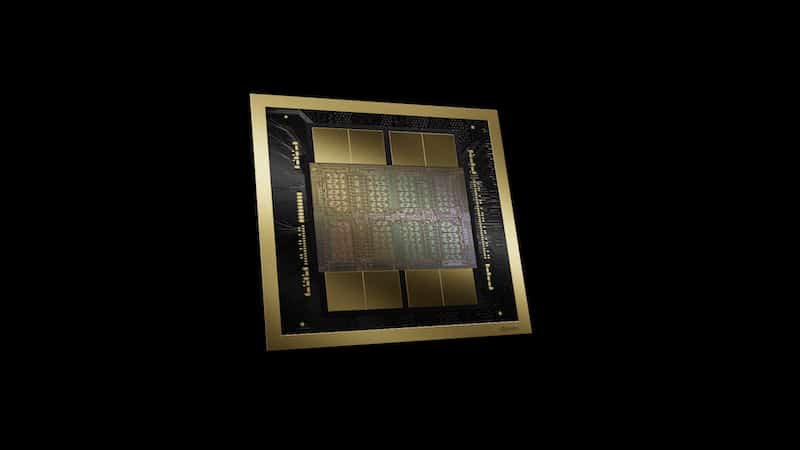

為因應人工智慧時代到來,NVIDIA推出首款深度學習運算系統DGX-1,其採用創新 NVIDIA Pascal技術支援的Tesla P100加速器打造,並已預先安裝多層次應用軟體,其中包含可加速所有主要深度學習架構的程式庫、NVIDIA Deep Learning SDK、DIGITS GPU訓練系統、驅動程式及CUDA。該系統包含容器建立和部署、系統更新及應用程式儲存機制的雲端管理服務存取。由於結合可在Tesla GPU上執行這些應用軟體功能等優勢,將其與各類舊版GPU加速解決方案的應用程式執行速度相比,速度最多可快上12倍。

同樣積極搶攻人工智慧市場,不讓NVIDIA專美於前,Intel於日前發表新一代Intel Xeon Phi處理器系列(代號Knights Mill),支援高效能機器學習與人工智慧。Knights Mill預計2017年問市,除了針對水平擴充分析系統進行最佳化,還將納入多項關鍵改良以支援深度學習的訓練。現今的機器學習應用方面,Xeon Phi處理器系列所增加的記憶體容量幫助像是百度(Baidu)這樣的客戶能更容易且有效率的訓練其模型。

為強調Xeon Phi處理器的性能優異,Intel於報告中強調該產品與現今GPU處理器之性能差異。報告中指出,Xeon Phi處理器的訓練速度比GPU快了2.3倍、Xeon Phi晶片在多個節點的擴展路為38%,且最多可達一百二十八個節點,這是目前市面上的GPU無法辦到的。同時,由一百二十八個Xeon Phi處理器組成的系統要比單個Xeon Phi處理器快50倍,意旨Xeon Phi處理器的擴展性十分優異。

然而,針對Intel之說法,NVIDIA提出了強烈的反駁,並於部落格中撰文指出,Intel使用的是18個月前的Caffe AlexNet數據,比較的是四個Maxwell GPU和四個Xeon Phi處理器。如果使用更新的Caffe AlexNet數據,就會發現四個Maxwell GPU比四個Xeon Phi處理器的速度快30%。事實上,採用四個Pascal架構的TITAN X GPUs,其訓練速度比四個Xeon Phi處理器快90%,而若採用新款DGX-1系統,更是快了5倍多。NVIDIA也補充,對於深度學習訓練,與其使用大量的弱節點,還不如使用少量的強節點,效果會更好。

無論兩邊引用數據基準為何,從上述雙方的隔空交火可看出,隨著人工智慧的重要性日益增加,晶片大廠間的競爭也更加激烈,用以強化自身優勢的策略也越來越多,如Intel除推出新系列Xeon Phi處理器,也於之前購併Nervana,強化其軟體演算能力,相信未來的人工智慧市場,還會再掀起更多波瀾。