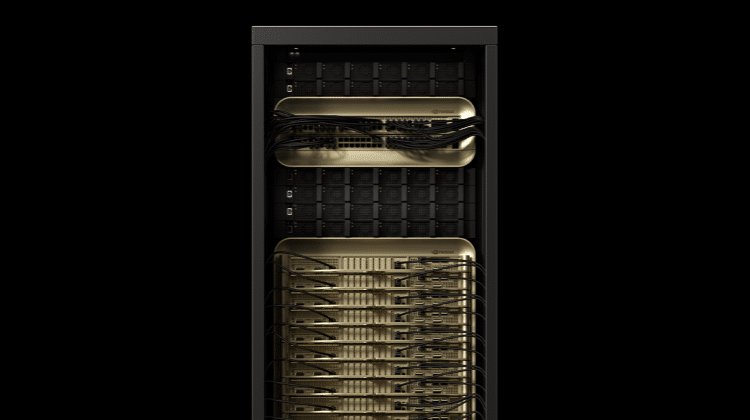

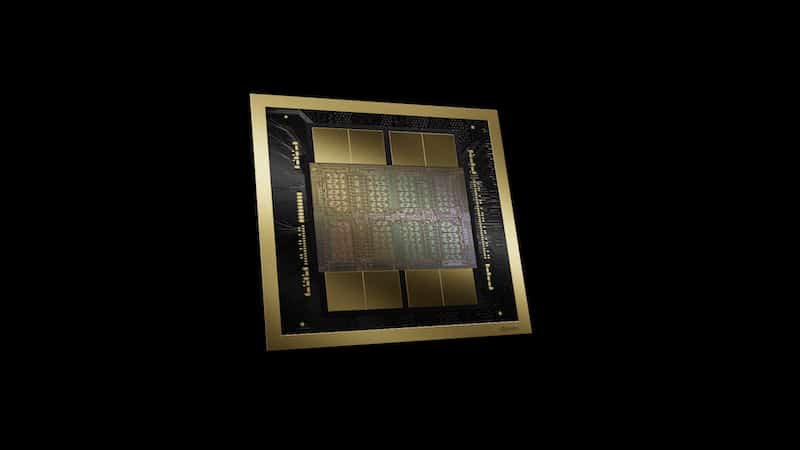

GPU模型推論效能不斷提升,各種邊緣運算裝置上所內建的人工智慧(AI)能力也變得更加強大。NVIDIA旗下軟體目前已可協助客戶做8位元與16位元的神經網路運算最佳化,不僅讓GPU模型的推論(Inference)更形完善,同時對硬體資源的需求也明顯降低,只需要一小塊電路板就能支援AI演算法。

針對邊緣運算日益漸增的需求,NVIDIA近期推出了新款開發版Jetson TX2,將整套人工智慧系統縮小在一塊電路板之上,為商用無人機、工業機械、智慧型攝影設備等領域,提供進階的導航、影像與語音識別功能。相較前一代產品Jetson TX1,Jetson TX2的效能提升了兩倍,耗電量則不到7.5瓦,能源效率提升了兩倍多。這讓Jetson TX2可在終端裝置上運行更大、更深的神經網路,進而開發出更高智慧化的裝置,並提升影像分類、導航以及語音辨識等作業的精準度與反應速度。

NVIDIA技術行銷經理蘇家興表示,對於訓練好的模型,NVIDIA也提供Tense RT軟體來協助客戶做模型優化、縮小化,其支援整數8位元與浮點數16位元的運算。目前的主流是以32位元的運算去做訓練,該16位元運算也就減少了一半,增加了一倍的效能,8位元則增加了四倍的效能,因此在模型推論上能運作的更好。

蘇家興進一步表示,無論是軟體還是硬體公司,都需要對訓練好的深度學習模型進行優化,除了邊緣設備會採用縮小化的模型,在伺服器與數據中心端,也會有某些情境需要採用這些優化過的模型去做推論。舉例而言,Facebook、百度在做語音辨識的推論時,若能透過優化的模型讓運作更快,勢必能讓消耗的功耗越少。

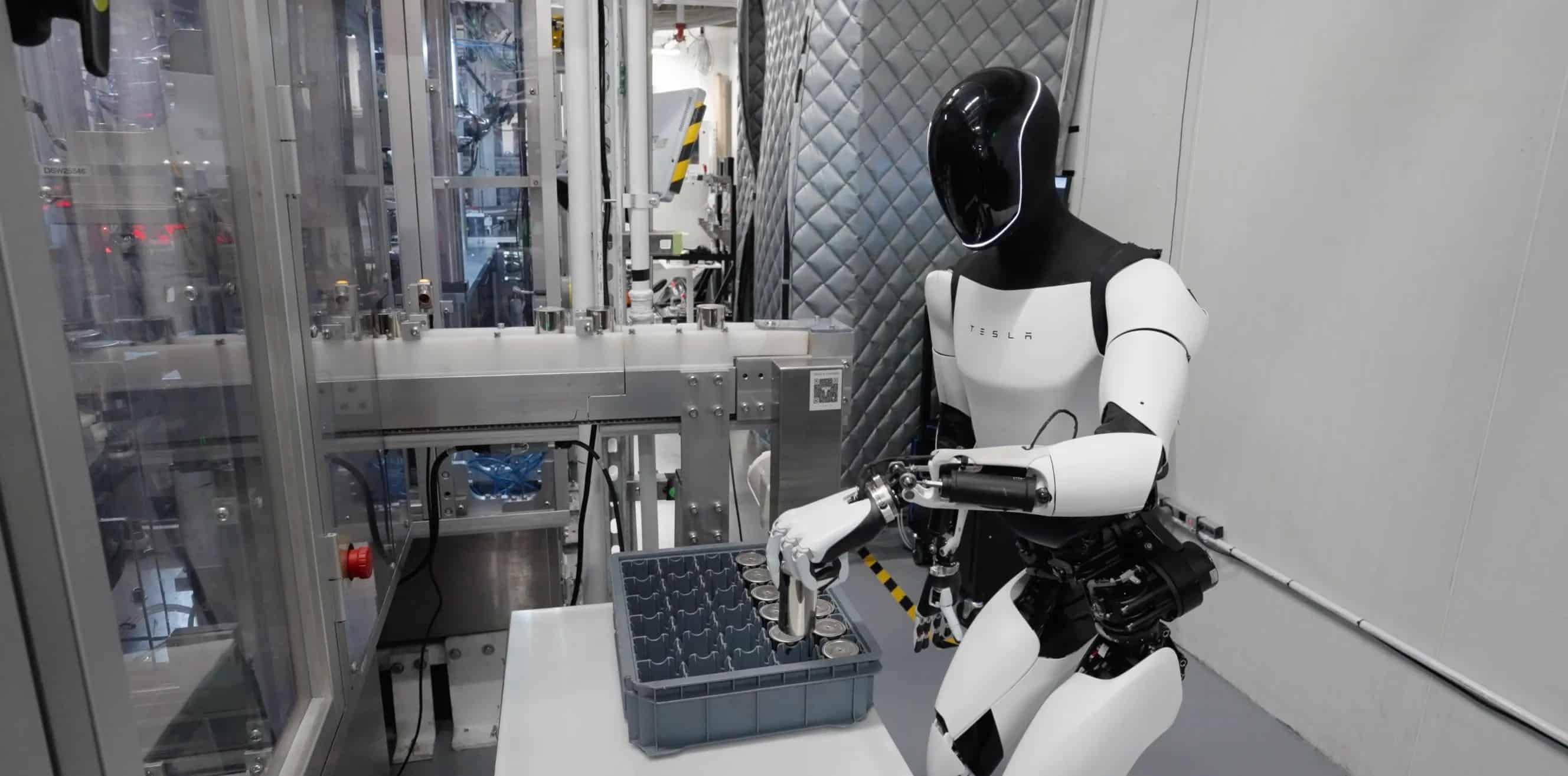

不過,也並不是所有的應用都適合做前端邊緣運算。以AlphaGo來看,其是以32台伺服器在做運算,因AlphaGo運算量非常大,所以就不太可能進行邊緣運算,因1台伺服器與32台伺服器運算的精準度,絕對是有差異的。若以語音辨識來看,即便可以同時採用在線與離線的方式進行,但精準度也勢必會有落差。

蘇家興指出,應用開發商必須盡快分辨出哪些運算任務適合採用邊緣運算,哪些部分還是得留在伺服器端執行。舉例來說,當無人機飛到有些沒有網路的地方,便必須運用邊緣運算,設計出可承載範圍內的推論。NVIDIA相信,未來數據中心與邊緣運算將會並存,但在瞄準的應用上必定會有所不同。