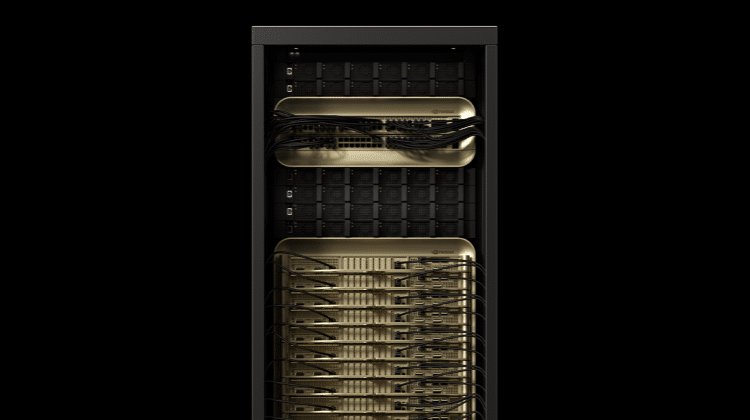

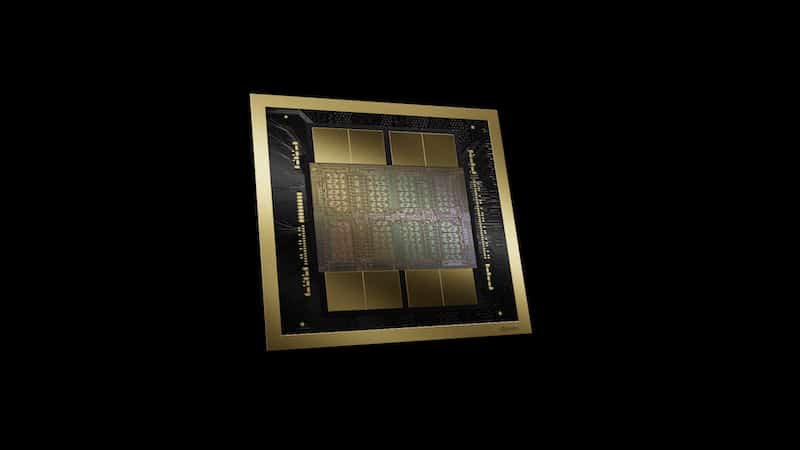

NVIDIA近期於GTC發布人工智慧(AI)推論平台的更新,以及提供企業大型語言模型(LLM),簡化語言模型的部署。推論平台的更新包含NVIDIA Triton推論伺服器軟體的新功能,可在所有AI模型及框架上提供跨平台推論,以及可最佳化 AI模型的NVIDIA TensorRT,為NVIDIA GPU上的高效能推論提供執行環境 (Runtime)。同時NVIDIA推出NVIDIA A2 Tensor核心GPU,用於邊緣AI推論的低功耗、小尺寸加速器,其推論效能較CPU高20倍。

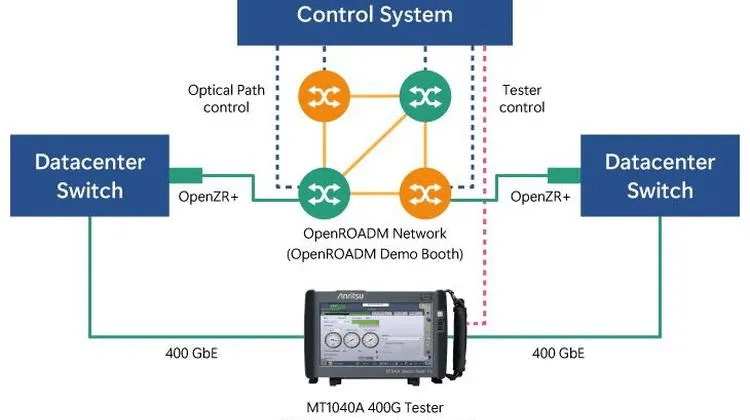

Triton在雲端、資料中心、企業邊緣及嵌入式裝置的GPU及CPU上提供AI推論服務,並支援AWS、Google Cloud、Microsoft Azure和阿里雲PAI-EAS。此外, TensorRT也整合TensorFlow 和 PyTorch,只要一行程式碼就能提供相較在框架內推論,加快三倍的效能。開發人員將能在使用TensorRT功能的同時,大幅簡化工作流程。

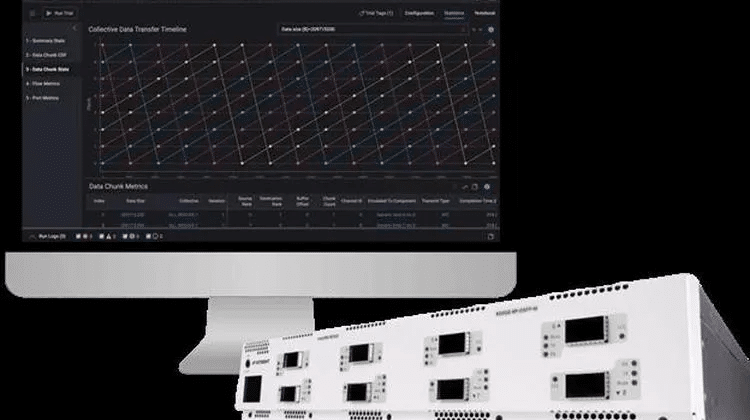

NVIDIA同步發表運用數兆個參數來訓練語言模型的NVIDIA NeMo Megatron 框架、可針對新領域和語言進行訓練的Megatron 530B可自訂LLM,以及搭載多 GPU、多節點、具分散式推論功能的NVIDIA Triton推論伺服器。這些工具結合 NVIDIA DGXTM系統,能提供可立即生產(Production-ready)的企業級解決方案,以簡化大型語言模型的開發與部署。

Megatron是由NVIDIA 研究人員帶頭的開源專案,研究大型Transformer語言模型的大規模有效訓練。NeMo Megatron框架協助企業克服在訓練精巧複雜的自然語言處理模型時面臨的挑戰,經最佳化處理後,可以在NVIDIA DGX SuperPOD的大規模加速運算基礎架構上擴充。NeMo Megatron利用可以匯入、管理、組織與清除資料的資料處理函式庫,自動化LLM訓練的複雜性。採用資料、張量與流程平行化的先進技術,把大型語言模型的訓練分散到數千個GPU。企業可以使用 NeMo Megatron 框架為特定領域和語言訓練LLM。

且NVIDIA Triton推論伺服器的多GPU、多節點功能,促使LLM推論的作業負載即時在多個GPU與節點上擴充。這些模型需要的記憶體數量不但超過單一 GPU、甚至超過搭載多個GPU的大型伺服器具備的可用記憶體,而推論則必須快速執行,才能在應用程式中發揮作用。