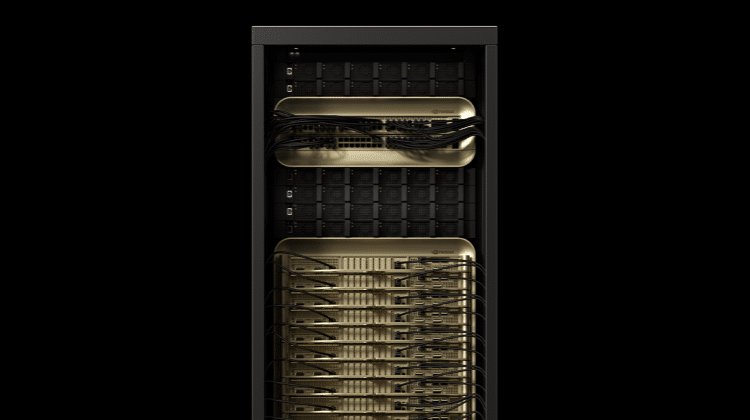

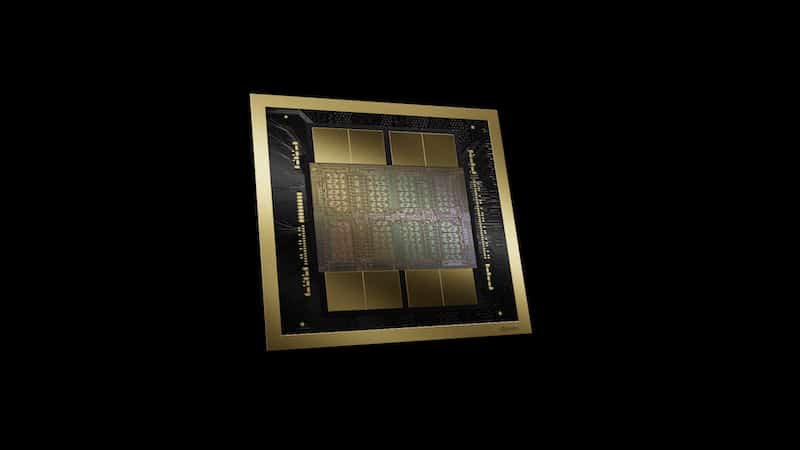

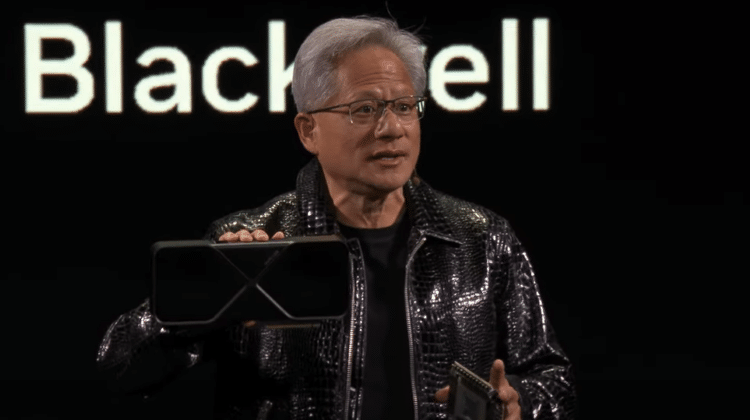

生成式人工智慧(AI)的運算需求持續增加,資料中心的效能也必須跟上。NVIDIA將於Hot Chips大會展示可提升資料中心效能,與能源效率的技術。NVIDIA Blackwell是全堆疊運算架構,由多種NVIDIA晶片組成,包括Blackwell GPU、Grace CPU、BlueField資料處理單元、ConnectX網路介面卡、NVLink Switch、Spectrum乙太網路交換器和Quantum InfiniBand交換器。NVIDIA架構總監Ajay Tirumala與Raymond Wong將介紹Blackwell平台,並且解釋這些技術如何相互配合,在提高能源效率之際,如何建立AI與加速運算效能的全新標準。

NVIDIA GB200 NVL72就是一個例子。這個一個多節點、液冷、機架規模的解決方案,能夠連接72個Blackwell GPU和36個Grace CPU。LLM推論作業需要低延遲、高輸送量的詞元產出。GB200 NVL72可以統掌全局,將大型語言模型(LLM) 工作負載的推論速度提高30倍,能夠即時執行有著上兆個參數的模型。

Tirumala與Wong將討論NVIDIA Quasar Quantization系統如何支援讓低精準度模型達到高精確度,並且重點介紹使用LLM與視覺生成式AI的範例。這個系統結合演算法創新、NVIDIA軟體庫與工具,以及Blackwell第二代Transformer引擎。

保持資料中心低溫

隨著研究人員開發出結合氣冷與液冷的混合式冷卻技術,以更有效率且更符合永續精神的方式解決資料中心的冷卻問題,以前使用氣冷式技術所發出的嗡嗡聲,或許會從此消失。液冷技術比氣冷技術可以更有效率地將熱度從系統中帶走,使得運算系統在處理大量工作負載時,同樣能保持低溫。而與氣冷系統相比,液冷設備占用的空間更小,用電量也更少,資料中心便能加入更多伺服器機架,以提高運算能力。

NVIDIA資料中心冷卻與基礎設施部門總監Ali Heydari,將介紹數種設計採用混合式冷卻技術資料中心的方式。部分設計是將現有的氣冷式資料中心改為使用液冷式裝置,以簡單方便的方式為現有機架加入液冷功能。其他設計則需要安裝管道,以便使用冷卻液分配裝置,或將伺服器完全浸入冷卻槽,以液冷方式直接冷卻晶片。這些選項雖然一開始要投入較大金額,卻能大幅節省能源消耗量和營運成本。

Heydari也將分享他的團隊在進行美國能源部,開發先進資料中心冷卻技術COOLERCHIPS計畫的部分研究成果。該團隊在這項計畫中使用NVIDIA Omniverse平台來建立有著物理根據的數位分身模型,有助於模擬能源消耗情況和冷卻效率,以設計出最佳的資料中心。

AI代理支援設計晶片

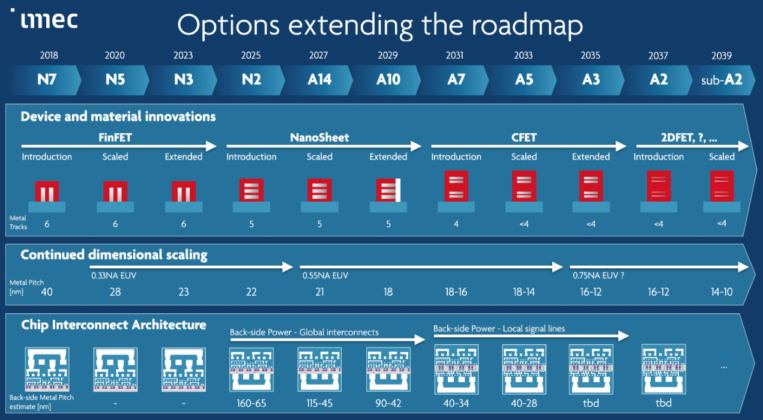

在極小的方寸之間要設計半導體,可謂一項艱鉅難題。開發尖端晶片的工程師要在幾英寸寬的晶片上,盡量塞入最大的運算能力,簡直就是在測試物理上可能達到的極限。AI模型可以提高設計品質和生產力,提高人工作業流程的效率,自動執行耗時的工作,以支援工程師的工作。這些模型包括協助工程師快速分析和改善設計的預測和最佳化工具,以及可以協助工程師回答問題、產生程式碼、執行設計除錯等作業的LLM。

LLM驅動的AI代理能接受指導後自主完成任務,就能在各行各業中創造出更多的應用方式。NVIDIA研究人員正在開發以代理為基礎的系統來協助設計晶片,這些系統能夠使用自訂的電路設計工具進行推論並採取行動、與經驗豐富的設計人員互動,並且從人類與代理的經驗資料庫中學習。

NVIDIA Blackwell演講活動將於8月26日登場,當中將簡單介紹該平台如何整合多種晶片、系統與軟體以驅動發展下一代AI,並且將重點介紹新的架構細節,以及在Blackwell晶片上執行生成式AI模型的範例。而在此之前,8月25日將進行三場教學活動,內容將涵蓋混合式液冷技術解決方案如何協助資料中心轉換成為更節能的基礎設施,以及包括LLM驅動的代理等AI模型如何協助工程師設計新一代晶片。這些內容共同展現出NVIDIA工程師如何在資料中心運算與設計的每個領域進行創新,以提供前所未有的效能、效率與最佳表現。